西田宗千佳のイマトミライ

第272回

Google怒濤の新発表 「Gemini 2.0」「Android XR」から見えるもの

2024年12月16日 08:20

年末に入って、大手ITプラットフォーマーが、生成AI関連技術のアピールを加速している。先週の本連載でAWSの取り組みを紹介したばかりだが、12月10日以降は、OpenAIとGoogleが競うように新技術を発表している。

Impress Watchに掲載された関連ニュースだけでもこんなにある。

12日間連続発表を公言しているOpenAIのニュースも多いが、それ以上に注目すべきはGoogleの発表だ。とにかく幅広い。

今回はこれらを俯瞰し、Googleがなにをしようとしているのかを考えてみよう。

1年でさらに進化した「Gemini 2.0」

GoogleのAIに関する発表の軸となっているのは、同社の基幹AIである「Gemini」の進化版である「Gemini 2.0」だ。Gemini自体の発表がちょうど1年前だったから、1年で大きくジャンプすることになる。

Geminiは当初より、画像・音声など多彩な情報を扱う「マルチモーダルAI」としての側面と、論理的理解力の双方をウリとして来た。1年前の発表では、動画が編集されていたことなどからケチがついた部分もあったが、その後矢継ぎ早に実装を進め、Androidへもコア機能として使われるようになっている。

Gemini 2.0で軸となるのは、Project Astraを含めたマルチモーダル性であり、AIになにかをやってもらう「エージェント性」の追求だ。

Project Astraは、人間との音声によるスムーズな応対に加え、カメラで捉えているものの論理的理解と記憶に長けている。人間は無意識にやっていることだが、人間とともに自然に活用されるデバイスを作るには、「周囲の情報の把握能力」がより人間に近いものである必要が出てくる。そこで即応性と理解力を強化しているのが「Gemini 2.0 Flash」、ということになる。

やっていること自体は、OpenAIやマイクロソフト、Metaにアップルなど、大手がどこも同じように目指しているものではある。

Googleのデモビデオの中では「ドアのロック番号を覚えておいてもらい、必要な時に教えてもらう」というシーンが出てくる。

これはMetaが「Ray-Ban Meta」とMeta AIの組み合わせで実現しているものに近い。

どこも発想はそこまで違う訳ではないのだ。

だがGoogleの場合、スマホからPCとウェブ、さらには後述するXR機器に至るまで、幅広い実装をすでにすすめているのが大きい。それらの機器で人間が実際に触れて、世界に散らばる情報をより有用に活用する……というのが狙いだ。

面白いのは、ここでGoogleがGemini 2.0の中でも、最も賢くて規模の大きいモデルではなく、速度重視の「Gemini 2.0 Flash」を前面に押し出していることだ。

OpenAIは、論理的思考の深さを特徴とする「o1」を差別化点としてアピールしている。

これは、o1に比べGemini 2.0の上位モデルが賢さで見劣りする可能性を示している。だが良い方向から見るなら「GoogleはAIの賢さよりも即応性を重視している」と考えることもできるだろう。実際、人が使う上では賢さよりも即応性が求められるシーンは多いものだ。

人とAIが同じ画面を見て協調作業する時代に

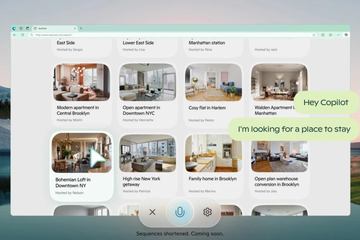

ブラウザを使いながら人とともに作業を進める「Project Mariner」も公開されている。

Geminiがブラウザ上の情報を把握し、人の代わりに一定のタスクを対話的に進める。自分ですべてをやるのではなく、Project Marinerにプロンプトを与えれば仕事をしてもらえるわけだ。詳しくは以下の動画をご覧いただきたい。

また、同時に公開された「ゲームプレイ・エージェント」の動画も興味深い。

ゲームをプレイしつつAIとコミュニケーションを取り、ゲームプレイについてAIが適切な助言をしている。しかもこのAIは、特定のゲームについて事前学習したAIではない。ユーザーが見ている画面をベースに、知識の多くはネット検索からカバーされている。

これは、ゲーム業界が抱える「ゲーム攻略情報とゲーム入門のアシスタント」「ゲームを一緒に進める存在の提供」という2つの課題を解決する。AIがネットから情報を集め、プレイの状況を見ながら助言してくれるなら、ネタバレを覚悟しつつプレイ動画や攻略情報サイトへアクセスさせるより、より体験が生まれるかもしれない。

これらに共通しているのは、マルチモーダルAIが画面上の情報を人間と同じように把握しつつ、人間のサポートをしているということだ。

人間が画面内の要素をすべて把握して操作するのは、そろそろ無理がある。多機能化や情報量の増加によってどんどん忙しくなるだけで楽にはならない。

しかしAIがアシスタント・エージェントとして間に入るなら、状況が変わっていく可能性がある。

マイクロソフトも「Copilot Vision」のテストを開始しているが、来年以降は、こうした「人とAIが同居して機械を使う」のがあたりまえの時代になっていくのかもしれない。

Googleがついに「XR用OS」を発表

今回Googleは、AIそのものの他に2つ発表を行なっている。

1つめであるXR機器向けのOSである「Android XR」を発表も、AIと大きく関係するものだ。

Googleは以前より、サムスンと共同でXR用OSとデバイスを開発中と公言していた。

最初にそのニュースが伝えられたのは2023年5月のこと。2023年中には発表になるとのことだったが、ジワジワと発表時期はずれ、2024年に「開発者向けの発表が行なわれる」という流れになった。現時点では、デバイス自体は正式発表されておらず、2025年に正式発表とされる。

2024年5月の「Google I/O」では前出のProject Astraが発表されているが、そのデモ動画の中でもスマートグラスでのデモと思われる部分があった。今回の発表でもチラ見せされ、さらにその翌日にAndroid XRの正式発表が行なわれた形だ。

ニューヨークでは開発者とプレス向けのイベントがあったようだが、日本からは参加したプレス関係者がいなかったようで、詳細なレポートはアメリカからの伝聞となっている。

ただ、開発者向けの情報はすでに公開されているので、基本的なイメージは把握できる。

Android XRとは、Androidをベースにし、XR機器に特化したUIを搭載したOSと言える。

どんなUIになるのかは、インタラクティブな動画が公式サイト上に作られているので、以下サイトから体験するのが近道だ。

Android XR 公式ページ

https://www.android.com/xr/

以前、GoogleのAndroidエコシステム担当バイスプレジデントであるサミール・サマット氏は、「まだ詳細は教えられないが」としつつも、「来たるべきXR対応Android」の方向性を次のように説明していた。

「XRに特化したUIを持ち、スマホ用のAndroidとは異なる。しかし、Google Play Storeから使い慣れたAndroidアプリをそのまま使える。そのエコシステムが大きなメリットだ」

これは、アップルにおけるiPhoneとApple Vision Proの関係に近い。ある意味、強いプラットフォームを持つものの王道と言える構成である。

Metaは今年春、OSを「Horizon OS」として公開し、ライセンス先による「互換機」販売を認めることを発表した。また、アプリストアも「Horizon Store」として再構築、PWAベースのウェブアプリやAndroidの2Dアプリ配布が行える形へと改修を進めている。

この戦略を発表した時、「Metaの直接競合はアップルではなくGoogleだ」と解説したが、実際その通りになりそうだ。

アップルはまだVision ProにAI関連機能をあまり搭載していないが、MetaはHorizon OSに「Meta AI」を搭載し、GoogleはAndroid XRに「Gemini」を搭載していく。

オンデバイスAIによるサポートは、XR機器にとって必須の要素となっていくのは間違いない。アップルも2025年中に、「Apple IntelligenceのVision Pro搭載」を進めるのではないだろうか。

なお前出のように、Android XR対応デバイスが出てくるのは2025年になってからだ。

リリースによればサムスン(コードネーム「Moohan」)の他、ソニー・XREAL・LynxがQualcommと組んでデバイスを出す、とされている。

XREALは先日新製品「XREAL One」を出したばかりだが、公式アカウントが次のように参入を大々的にアナウンスしている。

... and we can't wait to share more!pic.twitter.com/JYcD7CX0MC

— XREAL 👓 (@XREAL_Global)December 13, 2024

なお、筆者はXREAL Oneの発表に際し、同社CEOに単独インタビューしている。その中で「今後の方向性」に触れた部分がある。脳内に「Android XRへ参入する」という情報を置きつつ読むと、色々考えられるものが見えてくるのではないだろうか。

1月のCESでは再度インタビューする予定なので、新情報が得られ次第お伝えする。

実は最大のニュース? 量子コンピュータ実現の課題を1つ解消

なお、今回の発表群の中で唯一、AIと直接関係しないのがGoogleの量子チップ「Willow」のニュースだ。

生成AIは大量の演算を必要とする。量子コンピュータはその負荷軽減に大きく貢献する技術ではあるのだが、今回の発表でいきなり「GPUから量子へ」と考えるのは気が早すぎる。

道などで大きく扱われる「最新のスーパーコンピュータで10の25乗という宇宙年齢をはるかに超える計算時間がかかるベンチマーク計算を5分未満で解決」という表現は、あくまでベンチマーク上のものであり、実際そういう計算が行なえる状態になったわけではない。

実用化・社会実装までにはまだまだいくつもの(乗り越える困難が大きい)山があり、到達時期のめども見えていない。

ただそれでも、なしとげた成果は圧倒的に素晴らしい。

Willowでは量子ビットを増やしたとしてもエラー率が上がらず、閾値以下の状態を達成したのだが、これにより、量子コンピュータ実現の課題の1つがクリアーされたことを示している。

見方によっては、先週Googleが行なった発表の中でも、最大のものといえるかもしれない。