西田宗千佳のイマトミライ

第288回

AIエージェント時代を本気で目指す Google Cloudの新戦略

2025年4月14日 08:20

4月9日から11日まで、米ラスベガスで開催されたイベント「Google Cloud Next '25」の取材に行ってきた。

このイベントは、Googleのクラウドインフラ部門であるGoogle Cloudの年次イベントで、同社の方針を知る上で重要なものでもある。

もちろん、軸となるのは生成AI。特に、そこからの延長線上にある「AIエージェントへの取り組み」は、どの企業も取り組む最優先課題だ。

では、AIエージェントを使った作業環境を実現するために、Google Cloudがなにをしているのか?

その部分にフォーカスしてまとめてみたいと思う。

実験を過ぎて「実装」の時代へ

生成AIの価値に疑問を持っている人は、そろそろいないとは思う。各社が全力で資本を投資しているのは、単に競争上の話だけではなく、生成AIとそこに紐づくAIエージェントの開発が、コンピューティングの未来自体を変えると考えているからだ。もちろん、Google Cloudも例外ではない。

Google CloudのCTOであるウィル・グラニス氏は、ラウンドテーブル取材の中で次のように発言している。

「1年前、我々はプロトタイプの話をしていたが、現在行なっているのは成果(Production)の話だ。すでに500社以上が実用のために開発に入り、多数のユースケースを披露している」

これが1つの本質だろう。

後述するように、新しい技術は多々ある。だがそれだけでなく、AIエージェント時代の到来を前提とした開発がまさに進んでおり、そのことを強調するイベントにもなっていた。

基調講演に登壇したGoogleのスンダー・ピチャイCEOは、その中で、「2025年にはトータルで750億ドル(約11兆円)の投資を計画している」と述べた。これは今年2月に公開した内容を再び強調したものだ。

AI投資については「加熱し過ぎている」「過剰ではないか」との声もあるが、Googleとしてはブレーキを踏まず、AI基盤としてのGoogle Cloudの強化を続ける……ということなのだろう。

こうした話になるのは、GoogleとGoogle Cloud自体が、生成AIの活用で大きな成果を上げつつあるからでもある。

ピチャイCEOは、「Googleで使われているコードの25%が、すでに生成AIによって作られている」とする。しかもどうやら、その比率は高まっており、直近では30%に近づいているという。

開発関連の情報でも、生成AIと連携するエディタを使い、GoogleのGeminiと連携して進める流れが当たり前のように説明された。

巨大なシステムのメンテナンスと進化は大変なことだ。その中で、生成AIを使ったコードの比率が増えているということは、それだけ開発効率が高い……ということでもあり、一つのトレンドを示している。

ハードを含めた多層的な価値がGoogle Cloudの強み

Google Cloudは、同社の強みを「4つのレイヤーが揃っていること」(Google Cloud・トーマス・クリアンCEO)とする。

4層とは、「エージェント」「Vertex AI」「研究開発とAIモデル」、そして「AIハイパーコンピューター」だ。

Vertex AIはGoogle CloudによるAIの統合型プラットフォームであり、多数のモデルを活用しつつサービス開発に利用できるもの。同社としてはLLM(大規模言語モデル)を直接いじるのではなく、プラットフォームを介して扱うことで開発効率とメンテナンス性を高められる……と主張している。

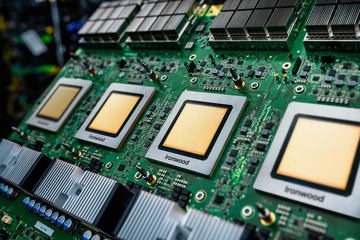

4つのレイヤーの中で、投資としても重要で大きな意味を持つのがプロセッサーだ。

Google Cloudは2018年以降、「TPU」という自社開発のAIアクセラレーターを使ったサービスを提供しているが、今回は「Ironwood(開発コード名)」という新たなTPUを公開した。

Ironwoodは学習にも推論にも利用できるが、どちらかといえば推論を強く意識した半導体である。これは、AIのニーズ増加に伴い推論のニーズが高まっていくという予測とも合致する。特に電力効率については、TPU v2(2018年)に比べ約29倍、2024年開発のTrilliumに比べ約2倍、効率が良くなっているとする。このことは当然、AIの利用コストに跳ね返る。

もちろん同時に、NVIDIAのGPUも積極的に活用、学習を中心とした高負荷なタスクにも対応する。

企業内での生成AIの利用については、その企業だけが持つデータの活用が重要でもある。そのため、「どこでどうデータを扱うか」も重要になる。データを国内に置いて処理する必要がある場合も多いし、顧客の持つデータセンター内に限定することを求められる場合もある。

Google Cloudは、同社の技術を、特定データセンターやエッジコンピューティング環境の中で動かす「Google Distributed Cloud」というサービスも提供している。これはハードとソフトを一体で提供する製品であり、要は「サービスを使う場所を限定するため」の仕組みである。

今回、Google Distributed Cloudの仕組みを使い、生成AIであるGeminiを動かす「Gemini on Google Distributed Cloud」が発表された。

その流れからか、KDDIはGoogle Cloudとの戦略提携も発表している。リリース内に「Gemini on Google Distributed Cloud」の名前はないものの、「2025年度中にGeminiをKDDIの大阪堺データセンターなどの国内インフラに組み込む予定」とされている。実質的に、Gemini on Google Distributed Cloudを国内顧客向けに提供するパートナーになると考えて良さそうだ。

マルチモーダル+AIエージェントで価値拡大

高い負荷が想定されるのは、ニーズが拡大することに加え、文字だけでない用途、いわゆるマルチモーダルなAIの活用が拡大していくと想定されるからでもある。

画像・動画・音声に加え、今回は音楽を生成する「Lyria」というAIモデルが発表された。現状は英語のみの対応だが、プロンプトからインストゥルメンタルの楽曲を生成する。

動画も、「Veo 2」でリアルさが増しているが、カメラの動きをシミュレートしたような動画生成を行なうなど、使い勝手が増している。

さらに、Gemini 2.5 Proによって扱えるコンテキストウィンドウ(AIが処理できるテキストや情報の量)が200万トークンに拡大したことが大きい。

Google Cloud Next '25開催の前日には、ラスベガスのライブ施設であるSphereで、1939年版『オズの魔法使』を、16K×16Kという、巨大な半球状のイマーシブスクリーン向けにリマスターすることが発表された。この作業にもVeo 2とGeminiが使われているが、映画の持つオリジナリティと一貫性を保ったまま生成ができるのは、Gemini 2.5 Proが大きなコンテキストウィンドウを持っていたから……だとか。

なお、Gemini 2.5 Proのコンテキストウィンドウの大きさは、コード生成にも有利だ。コードにおいてもプロジェクト全体の一貫性は重要なものであり、生産性向上に寄与する。

マルチモーダル性を活かすことは、サービス自体の価値を変える。

以下の画像は、基調講演でのデモのものだ。

販売サイトでのフロントエンドを音声でAIが担当している。音声で自然に対話できるのはもちろんだが、顧客がどんなものを求めているのかを理解し、さらに値引き要求には人間のスーパーバイザーへの判断も仰ぐ。作業に行く時間のアポイント設定まで、一貫してAI が人間とともに、自然な対応を実現している。これは、マルチモーダルかつリアルタイムな反応ができるAIモデルがあり、さらにそれを活かすAIエージェントを活用したサービスが構築できる……ということを示している。

別の例もある。以下は、「ショッピングコンシェルジュ」として作られたデモだ。音声や画像で求める商品を検索し、提案する。自宅のインテリアにどう馴染むか、という姿まで生成して提示してくれる。

実はこのデモ、日本側で開発されたものであり、デモのデータとしてはメルカリから提供された商品群の画像などのデータが活用されている。詳しくは以下の動画をご覧いただきたい。デモ自体はオープンソースで公開されるので、これをベースに自社のサービスを作ることもできるだろう。

AIエージェントのためのプロトコルも整備

これらの構築には、複数の作業をAIが自律的に処理していく「AIエージェント」の活用が必須だ。

今回Google Cloudは、AIエージェントの開発効率向上について、複数の技術を発表している。

中でも重要なのが「Agentspace」と「Agent2Agent」だ。

AgentspaceはAIエージェントを開発するためのプラットフォーム。企業内の様々なデータソースへとアクセスし、分析し、理解する仕組みを持ち、専門知識を持たない従業員でも、日常的なタスクのためのエージェントを開発できる。また、専門性のあるエージェントについては「Agent Gallery」を経由して探し、ワークフローの中に組み込める。

さらに、そこで「マルチエージェント」を活用するために使われるのがAgent2Agentだ。

これはGoogleがオープンソースの形で提供する新しいプロトコル。AIエージェント同士が情報を交換し、コラボレーションしながら作業を行なうためのものだ。AIエージェントがどんな能力を持っているかをAgent Cardとして公開し、それを元にどう連携するかを定めていく。

重要なのは、Agent2Agentによって、異なる企業が提供するAIエージェント同士が連携しやすくなるということだ。

基調講演には、セールスフォースのマーク・ベニオフCEOが動画でメッセージを寄せた。同社は「Agentforce」というAIエージェントを展開しているが、これもAgent2AgentによってGoogle CloudのAIエージェントと共同作業を行なえる。

Agent2Agentは50社以上のパートナーとともに開発されており、かなり準備が進んだ段階での発表となった。

生成AIとAIエージェントの連携という意味では、Anthropicが2024年11月に発表した「MCP(Model Context Protocol)」が注目されている。AIに対する外部データ連携、という意味ではAgent2Agentに似たところがあり、位置付けが気になるところだ。

Google Cloud側は両者を「補完的な位置付け」と説明する。MCPはLLM自体がデータに接続するためのメカニズムであり、Agent2AgentはAIエージェント同士の連携を目的としている。AIエージェント単体の価値を上げるにはLLMとMCPによるデータ連携が必要であり、さらにそこから異なるフレームワークで動くAIエージェント同士が動くことになると、Agent2Agentの出番になる……と考えれば良さそうだ。

こうした、企業間での連携も視野に入れた仕組みが提案されていることこそが、「AIエージェントを真剣に社会実装していく」ことへの道筋なのだろう。