西田宗千佳のイマトミライ

第263回

再始動する「Copilot+ PC」 “スマホを出さない”へ向かうオンデバイスA

2024年10月7日 08:20

今年のトレンドに「オンデバイスAI」があるのは疑いない。

クラウド等に接続せずに、デバイス内でAI処理を完結する「オンデバイスAI」。なにができるかという、打ち出し方は各社まちまちではあるものの、その軸に「画像の内容把握」がある。

それを早期から強く意識していたのがマイクロソフトだ。

ただ、マイクロソフトは「Copilot+ PC」を5月に発表していながら、プライバシー問題からウリの機能である「Recall(リコール)」は提供が延期されていた。

だが、この10月、ようやくWindows Insiderプログラムを介したテスト公開がスタートする。同時に、生成AIを使った多数の機能が追加されることが発表された。

iPhoneやGalaxyなどのハイエンドスマホ、PixelのようなAI特化スマホでの差別化点はオンデバイスAIを使った機能となっているし、PCでも「Copilot+ PC」はオンデバイスAIで差別化したPC、と言える。MacにしてもiPadにしても、今年出た製品はみなApple Intelligenceが動作することを前提とし、やはり、オンデバイスAIが差別化点である。

今回はマイクロソフトの施策を軸に、「画像分析とAI」の意味を考えてみよう。

Recallはどう「再始動」するのか

まず、Copilot+ PCに搭載される「Recall」がどんな機能だったかを振り返ってみたい。

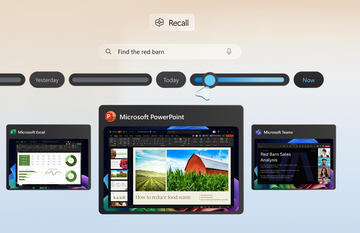

Recallは「PC上で見たものについて、オンデバイスで動作するCopilotに聞けば、いつどのタイミングで見た情報だったかを教えてくれる」機能だ。

文章もしくはキーワードで探したいものを入力すれば、タイムラインの形で、関連するファイルやウェブで見た情報を表示してくれる。例えば「赤い車」と書けば、赤い車の絵や写真、赤い車に類する言葉が含まれる文章が含まれた情報が出てくるわけだ。

背後では、スクリーンショットを自動的に撮って、その内容をオンデバイスAIが解析する仕組みが動いている。画像内に含まれる文字や、画像に写っている内容を解析するのにAIが動いているわけだが、個人のPCでどんなことが行なわれているのかはプライバシー情報の塊なので、クラウドではなくデバイス内で動作するAIが使われている、ということになる。

ただそれでもプライバシー面では懸念がある。5月の発表後にそうした声が大きくなったため、「生体認証を必須とする」「そもそも記録されると危険である情報を記録しない」などの対策が追加され、搭載が10月まで延期された経緯がある。

その結果として、6月に発売されて以降も、Copilot+ PCはあまり魅力が上がらなかった。盛り上がりに欠けた理由をRecallの不在だけとするのは難しいが、原因の1つとは言えそうだ。

筆者の手元にも評価機材として、Snapdragon Xを搭載した「Surface Pro(第11世代)」があるが、「Snapdragonで動作するWindows 11搭載PC」であること以上の価値があまり出ていない。機材到着の遅れもあったので「Recall搭載まで評価記事の執筆を待つ」ことにしたのだが、気がつくと10月になっていた。

どのようなセキュリティ強化が行なわれたかは以下の記事で書いている。

ざっくり言えば、

- 利用時には必ずWindows Helloを通して認証する

- 情報は仮想化された領域に記録され、Windows Helloを通した個人認証を経ないとアクセスできない

- 機密性の高い情報と識別されたら記録しない

- 著作権保護された情報は記録しない

というところだろうか。通常のWindows上のプロセスからもアクセスできない仕組みなので、相当に強固と言っていい。

一方で、TPM 2.0による暗号化に対応していないPCは使えない。Windows 11の動作要件にも入っているし、Copilot+ PCは全てTPM 2.0対応PCなので当然……とも言えるのだが、今後デスクトップPCなどにCopilot+ PCが広がっていく際には、ここも課題になるかもしれない。

Recall的AI活用はWindowsの中でさらに拡大

Recallの初期のセキュリティ設計がどうだったかは明確ではない。しかし、マイクロソフトが時間をかけて「出直し」したということは、懸念される課題もあった、ということなのだろう。

ただ、それだけ時間をかけたとしても、マイクロソフトは「Recallは必要で重要な機能」と考えていたのは間違いない。

というのは、AIをPCに搭載するといっても、それをどこで使うかはけっこう難しい課題なのだ。

単に質問をしたり要約・翻訳をお願いしたりするのであれば、ウェブ経由での利用であっても問題は少ない。よりパーソナルで幅広い使い道を考えた場合、Recallのように「個人のために情報を分析して提供する用途」が必須、ということでもあるのだろう。

そして、マイクロソフトが「Copilot+ PC向けの機能強化」として追加してきた機能は、どれもオンデバイスAIによる画像解析が必須なものだった。

「Click to Do」は、表示されている画像の内容を認識し、その場で可能な処理を呼び出せるようにするもの。右クリックで呼び出せる「コンテキストメニュー」をオンデバイスAIで強化したような内容だ。

OS標準のファイル検索も、Recall的な強化がなされる。従来はファイル名を手がかりに検索する機能だったが、AIが画像の内容を解析し、その内容を文章で検索する機能が追加される。例えば「バーベキューパーティー」と検索すれば、ファイル名が連番のままだったとしても、内容をもとに見つかるようになるわけだ。

これらは結局、今のPC操作における「人間が覚えておいたり、判断したりしなければならないこと」のAIが一部カバーしている、ということになる。

スマホでも続々と「画像解析を使った機能」が登場

これは、AIの活用方法としてかなり妥当で、いろいろな企業が目指す方向とも一致している。

画像を生成するのも文章をまとめるのも大事なことだが、皆がスマホやPCの中で日常的に求めていることは「もっと負担を減らして楽に使うこと」であるから、記憶をカバーする要素を増やすのは重要なことになる。

例えばGoogleは、今秋発売した「Pixel 9」シリーズに「Pixel Screenshots」という機能を搭載した。

といっても、現状は英語環境のみで使えるもので、日本語だと出てこない。以下のスクリーンショットは英語設定に切り替えて作ったものである。

Pixel Screenshotsは、Pixel版のRecallとスクリーンショットの解析検索を組み合わせたようなものだ。メモしておきたいもののスクリーンショットを撮ると、いわゆる画像保存とは別にデータベースが作られ、その中で「含まれる内容」をベースに検索ができるようになる。

Recallとの違いは「自分で撮ったスクリーンショットだけが残る」ので、プライバシー面の課題が起きづらい、ということだ。

アップルが同社製品に搭載する「Apple Intelligence」でも画像検索はかなり高度化されていて、Windowsの検索やPixel Screenshotsのような検索は十分に行なえる。

また、年末までには「Visual Intelligence」という、Google レンズのアップル版的な機能も追加され、「画像をスマホでインテリジェントに活用する」方向性が強化される。

Metaのスマートグラスである「Ray-Ban Meta」では、見たものを覚えておき、あとから声で教えてもらう機能が搭載されている。

「ホテルの部屋番号を覚えておいて」とか「駐車場の番号を覚えておいて」「この本のタイトルを覚えておいて」というと、次に「あの番号なんだっけ」などと聞くと、ちゃんと声で教えてくれる。

AIによる解釈と記憶をセットにすることで、「利用者が覚えておく」という必要性を減らすわけだ。

これが将来的にARと連動して「音声だけでなく画像でも教えてくれる」ようになれば、可能性はさらに広がるだろう。

同じ画面を「AIと人間がともに見る」時代がやってくる

マイクロソフトはさらに面白い要素もテスト公開している。それが「Copilot Vision」だ。

まずは以下の動画をご覧いただきたい。

このビデオの中では、PCの画面を見ながら、その内容についてユーザーと「PC内のCopilot」が自然な対話を行なっている。

機械との対話という意味で、「同じもの=画面に表示された内容」を把握して対話できる、というのは大きな進化である。さらに言えば、この先のありようとして、画面にある要素を理解した上で「ユーザーの代わりに操作してもらう」ことも可能になる。すでに一部、ソフト側で対応することで実現している要素ではあるが、「画面を把握する」「マウスやキーボードを代わりに動かす」ということをPC側が行なうようになれば、「あれやっといて」とお願いするだけで、複数の操作をして目的を達成する……ということも可能になってきそうだ。

もちろんそこでは、他人にCopilotを操作されないようにする必要が出てくる。Recallで導入しているセキュリティモデルは、こうした部分でも必要となるだろう。

AIがスマホ内の行動を遡る機能を持ったり、操作を自分の代わりに実行するようになれば、我々はちょっとしたことを行なう際に「PCやスマホをカバンやポケットから取り出す」必要が薄くなっていく。ヘッドフォンだけで操作したり、AR対応スマートグラスで操作したりするには、そうしたAIのサポートが必須だ。

現在オンデバイスAIで各社が目指しているのは、そうした「AIと人間の協調動作」の第一歩と言える。

スマホやPCをその機能の有無だけで買い替えるのはまだ難しいが、スマホやPCのありようを変える第一歩になり得る。

だから各社は注力しているのだ。そしてそれは、クラウドでの「巨大で賢い生成AI」とはまた別の軸として進化していくのだろう。