いつモノコト

視界を記録できる体験 「Ray-Ban Meta」とARグラスの可能性

2024年12月19日 08:40

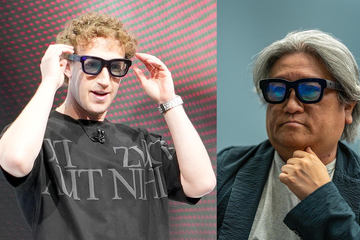

FacebookやInstagramなどのSNSに加えて、QuestというVR製品も提供するMeta。AR製品のプロトタイプとして「Orion」も発表していますが、同種の製品として「Ray-Ban Meta」がすでに海外では発売されています。

ARやVRに力を入れるMetaの戦略については西田宗千佳氏のレポートに詳しいですが、VRについてはすでにQuestでその一端を体験できます。MetaのARの技術の一端を体験すべく、まだ日本では発売されていないRay-Ban Metaを海外で購入してみました。

「視界に写ったものを記録できる」の素晴らしさ

Ray-Ban Metaの発売は2023年9月。すでに1年以上が経過している割に、販売地域は欧米の一部に限られています。今回筆者は、フランス・ニースの眼鏡店で購入。329ユーロでした。

Ray-Ban Metaの機能としては、前面に搭載したカメラでの静止画・動画の撮影、SNSへの送信、ストリーミングによるSNSへの動画配信に加え、音声による各種コントロールもできます。「Meta AI」をサポートし、言葉による質問への回答やカメラに映った被写体の認識もしてくれます(回答は全て音声)。

ただ、Meta AIは対応エリアがさらに限られていて、フランス版のせいか、現時点で筆者の手元ではMeta AIは利用できていません。さらにいわゆる「技適」は取得されていないため、国内では一時的なテスト用途として技適未取得機器を用いた実験等の特例制度を活用しています。

Meta AIは非サポートとは言え、スマートグラスとしては優秀です。これまで、音楽を聴けるオーディオグラスとして「HUAWEI Eyewear」も愛用していました。Bluetoothでスマートフォンと接続して音楽を聴いたり、マイクも搭載するので音声通話をしたり、ビデオ会議で使ったり、AIアシスタントを起動して音声で質問をしたり、といった使い方ができます。

Ray-Ban Metaは、同様にツルから音が聞こえるので音楽を聴くことができるし、マイクを搭載しているので通話などにも利用可能。オーディオグラスとの違いは、ほぼ「カメラを搭載するかどうか」でしかないのですが、このカメラの違いが大きいのです。

メガネは自分の視界そのものなので、その視界に映ったものがそのまま記録できるというのはインパクトがあります。Ray-Ban Metaで記録される画像は縦位置で記録されるので、「視界」という意味では不自然なのが残念(人間の視界は横長)ですが、スマートフォンもカメラも構えることなく撮影できるのがいいところです。

画質面では「安価なスマートフォンカメラ」レベルで、動画撮影時間も3分までと制限はありますが、シャッターボタンだけでなく「Hey Meta, Take a photo」などと言えば、ハンズフリーで眼前の景色を撮影できます。

スマートフォンとの接続にケーブルがいらないというのもうれしいところ。普通のメガネと同様に装着するだけで使い始められるのは、体験としては大きな優位点です。

Ray-Ban Metaはメガネという構造上、カメラに前髪が写り込む場合があり、その場合は警告メッセージが流れます(何となく、欧米人の男性はあまり前髪をたらさないように思います)。現時点では試せていませんが、Meta AIでは、カメラに写ったものを音声で説明してくれるそうです。つまり、コンピュータビジョンが世界を認識してそれを伝えてくれるような機能が搭載されているわけです。

Ray-Ban Metaから考えるARグラスの将来像

こんなRay-Ban Metaなのですが、ディスプレイが存在しないことから限界も感じます。その点、Metaが開発中のARグラス「Orion」はディスプレイを内蔵して、眼前に映像が表示できるようです。また、例えばXREALやNTTコノキューデバイスのMiRZAといった製品も表示機能を備えています。

映像を表示するとなると、デバイスとしてはどんどん大型化し、メガネからかけ離れていきます。特にプロジェクター部分をどこまで小型化できるか、ディスプレイを薄く高精細化できるか、バッテリーがどこまで持つかという点は課題でしょう。

とはいえ最近はメガネ型に近づいており、Orionもだいぶ小さくなっています。デバイスとしては「メタレンズ」あたりも期待できるかもしれません。

さらにUWB技術もARグラスには適しているように感じます。現在はスマートフォンへの搭載が進んでいて、AirTagのような一部の紛失防止トラッカーに内蔵されています。紛失物を探す際にスマートフォンとの方向や距離を正確に測定するセンサーとして使われているほか、車のキーレスエントリーや、決済端末と通信して手ぶら決済のような使い方も想定されています。

UWBは、一昔前は「ワイヤレスUSB」とも言われていた技術です。当時は通信速度として480Mbpsが想定されていたのですが、要は「短距離低消費電力で高速データ伝送が可能」という特徴を備えます。一般的なARグラスなどが必要とするケーブルを排除できる可能性があるわけです。

MetaのOrionは、ホストデバイスとワイヤレスで繋いでいるようです(通信技術は未詳です)。XREALなどはスマートフォンと有線で接続するので、そうしたデバイスはUWBであればムダがないでしょう。

Ray-Ban Metaを使ってみるとやはり、「よりメガネに近く、より自然に装着できる」ことがARグラスの必須条件と感じました。このあたりは、そのARグラスの用途が「必要なときにだけ装着する」ものなのか、「常時装着しておく」ものなのかでスタンスは異なるのだと思います。

現時点のARグラス製品では、「常時装着しておく」のは難しいでしょう。ケーブルも必要だしサイズも大きい。バッテリー問題もあります。ただ、やはりOrionの方向性とRay-Ban Metaの利用をあわせると、最終的にARグラスは常時装着する方が真価を発揮するのだと感じます。

Orionのデモ映像にもあるように、物や人を認識してタグ付けをしてくれる機能などは、普段使っているからこそ生きる機能です。

そして常時装着できるようになると、ARグラスには現実の認識だけでなく、「現実の操作」もできるようになってほしいと思うのです。

例えばMeta Quest 3やApple Vision Proはビデオシースルーで外界の景色をリアルタイム映像として表示します。普通のARグラスはガラス面を通しただけ(光学シースルー)の外界の景色にCGを重ねます。ただ、それだと外界の景色の操作はできません。

カメラのファインダーは、OVF(光学式ファインダー)からEVF(電子式ファインダー)に変わって、撮影設定を重ねて表示できるようになり、検出した顔にマーカーが付くようになりました。拡大してピント合わせをすることもできますし、再生画像の表示もできます。片目で覗くカメラのファインダーは、もう片方の目を開いて周囲の状況を確認しながら撮影することもあるので、映像と現実が(頭の中では)重なった状態になっています。

こうしたイメージを総合していくと、「ARグラスの一部(もしくは全体)がディスプレイ化して映像をリアルタイムで表示する」ようになったら、より便利な世界になりそうだと感じるのです。

新聞や食品パッケージの原材料表示のように小さい文字を読もうとして、拡大しようと紙の上でピンチアウトしてしまうことはないでしょうか。ARグラスがディスプレイ化したら、ARグラスのカメラの前で指をピンチアウト操作したら目の前の景色が拡大表示される、フリックしたら自分の見ていたシーンが巻き戻る。そんな操作ができるようになるかもしれないのです。

カメラとAIを駆使すれば、機器のカメラに映る指の動きはすでに検出できます。目の前に指を出してピンチアウトしたとき、ビデオシースルーならば目の前の現実を拡大して、「遠くの人の顔を拡大する」といったことだってできます。

目の前の人を顔認識して名前や自分との関係を表示する、ルートの矢印を表示して目印の建物にタグを表示するといったことは今でも(恐らく)できるでしょう。通り過ぎた景色を巻き戻して目の前に表示することもできるかもしれません。

とはいえ、技術的にも法的にも難しい話なので、現時点では現実性が薄いのが実情です。逆に音声だけのARグラスの可能性も検討してみると、これはこれでありえます。すでにRay-Ban MetaとMeta AIが実現していますが、カメラとAIの高度化によって、できる可能性はさらに広がります。

指で示した場所をカメラが検出して「これはなに?」という質問に答えたり、マイクを使って外国語の音声を同時通訳してくれたりといっただけでなく、色々な活用法がありえそうです。現時点でAIなのに言語で制限されるというのが中途半端ですが、こうした言語バリアは今後も課題となるでしょう。

いずれにしても、「常に装着するARグラス」としては音声だけの方が現実味はありそうです。ARなのかと言われると難しいところですが、「現実に音を重ね合わせる」という意味ではARグラスと言っていいでしょう。

というわけで、Ray-Ban MetaによってARグラスの将来像に思いをはせることになりました。問題は開発の継続性ですが、Metaは諦めず、さらにProject Astraで同様のスマートグラスを紹介しているGoogleなど他社もますますの競争を進めてほしいところです。